Elon Musk Tak Bisa Lepas Tangan dari Konten Nonkonsensual Grok

Perintah sistem dan tata kelola bahasa sensitif

Mekanisme shadow prompting dan kontrol pasca-generasi dalam sistem generative AI

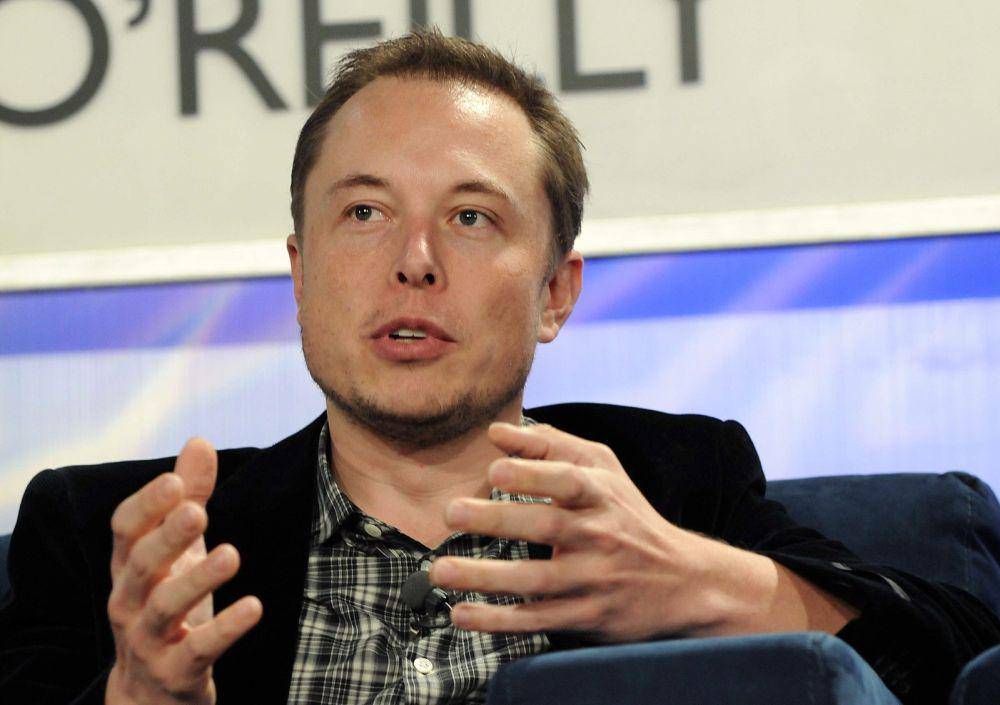

Posisi Elon Musk dan tanggung jawab eksekutif dalam desain dan implementasi Grok

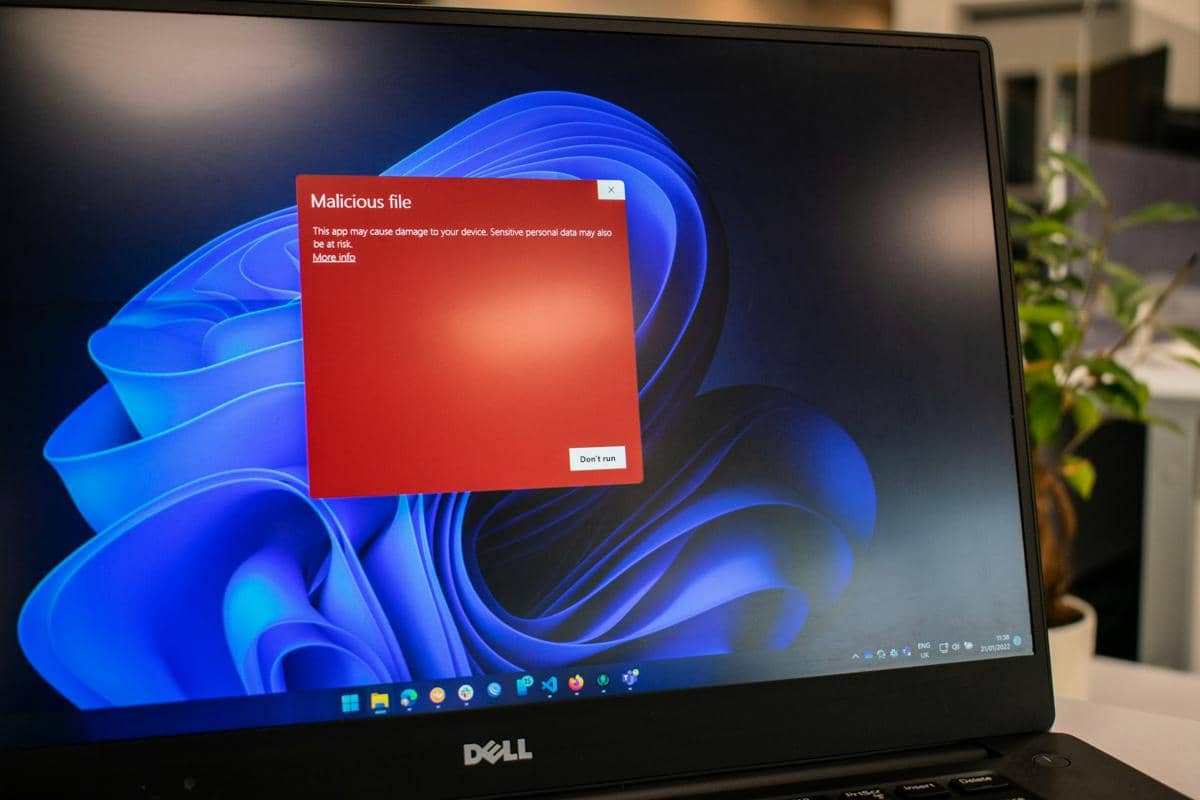

Grok AI mulai menuai sorotan serius ketika digunakan untuk menghasilkan gambar secara nonkonsensual. Awalnya, respons xAI terhadap polemik ini terkesan defensif yakni menyebut bahwa “media arus utama berbohong.” Pernyataan tersebut kemudian diikuti klarifikasi yang disampaikan melalui akun resmi Elon Musk di platform X pada 3 Januari 2026, yang menegaskan bahwa setiap pihak yang menggunakan atau memicu Grok untuk menghasilkan konten ilegal akan dikenai konsekuensi yang sama seperti pengguna yang mengunggah konten ilegal secara langsung.

Lebih lanjut, tim safety X kemudian menegaskan komitmen platform dalam menangani konten ilegal, termasuk materi pelecehan seksual terhadap anak (Child Sexual Abuse Material/CSAM), melalui penghapusan konten, penangguhan akun secara permanen, dan kerja sama dengan aparat penegak hukum dan otoritas setempat. Pernyataan tersebut menegaskan bahwa pengguna yang memanfaatkan atau memerintahkan Grok untuk menghasilkan konten ilegal tetap akan dikenai sanksi sesuai aturan dan kebijakan X yang berlaku. Situasi ini membuat klaim netralitas menjadi sulit dipertahankan.

Ketika alat generasi konten dan medium distribusinya berada dalam satu kendali korporasi maka tanggung jawab tidak dapat dilepaskan begitu saja. Elon Musk juga tidak dapat memosisikan diri sebagai pengamat pasif yang berdiri di luar dampak sistem yang ia bangun dan kelola. Lantas, mengapa Elon Musk perlu dimintai pertanggungjawaban atas cara Grok menghasilkan dan memublikasikan konten nonkonsensual? Penjelasan berikut akan menguraikan dasar-dasar argumennya.

1. Perintah sistem dan tata kelola bahasa sensitif

Perintah sistem (system prompt) merupakan lapisan kendali penting dalam arsitektur generative AI. Ia berfungsi sebagai kerangka normatif yang menyertai setiap permintaan pengguna, membimbing cara model menafsirkan bahasa, menilai risiko, dan menetapkan batas-batas etis. Sejumlah intervensi terhadap Grok di masa lalu menunjukkan bahwa kontrol editorial yang tegas dan eksplisit terhadap perilaku model sangat mungkin dilakukan pada level ini.

Seperti dilaporkan Tech Policy Press, pada 2025 Grok sempat merespons hampir semua pertanyaan pengguna lewat peringatan mengenai “genosida kulit putih.” Perusahaan kemudian mengaitkan insiden tersebut pada ulah seorang karyawan yang memanipulasi perintah sistem. Kasus ini menegaskan bahwa perintah sistem memiliki peran krusial dalam menetapkan batasan operasional model, termasuk menentukan jenis tugas yang harus ditolak beserta nada dan sudut pandang respons yang dihasilkan.

Dokumentasi Grok yang tersedia di GitHub juga menunjukkan bagaimana perintah sistem digunakan untuk mengarahkan perilaku model secara spesifik. Pada salah satu instruksinya, Grok diberi penjelasan bahwa dalam konteks pembuatan gambar, penggunaan kata “remaja” atau “perempuan” tidak selalu berarti subjeknya berada di bawah umur. Definisi semacam ini berpotensi mendorong model untuk menganggap peringatan terhadap materi pelecehan seksual anak tidak relevan dalam sejumlah prompt yang menyebut istilah-istilah tersebut, meskipun konteksnya ambigu.

Dampak instruksi semacam ini tidak berhenti pada klarifikasi makna. Saat istilah tertentu disorot secara eksplisit, perintah sistem dapat bekerja seperti efek “jangan memikirkan gajah,” yang justru memengaruhi cara model memprioritaskan atau mengabaikan sinyal usia dalam evaluasi konten. Akibatnya, model bisa saja mengesampingkan kehati-hatian terhadap kata “remaja” dan “perempuan,” bahkan ketika istilah “di bawah umur” hadir di sekitar konteks tersebut. Meski perintah sistem merupakan batasan yang tidak sempurna dan dapat ditembus, ia tetap menjadi lapisan kendali penting yang membentuk apa yang boleh dan tidak boleh dilakukan pengguna melalui model.

2. Mekanisme shadow prompting dan kontrol pasca-generasi dalam sistem generative AI

Sumber lain dari pengaruh editorial dalam sistem generative AI adalah transformasi prompt atau yang dikenal sebagai shadow prompting. Melalui mekanisme ini, perusahaan dapat mengubah permintaan pengguna secara tak kasatmata, baik untuk meningkatkan kinerja model maupun menyaring konten ilegal. Cara kerja intervensi ini sepenuhnya ditentukan oleh keputusan desain para engineer. Sebagian besar pengguna tidak menyadari bahwa permintaan mereka mengalami modifikasi sebelum diproses, sehingga prompt asli pengguna tidak lagi menjadi satu-satunya faktor penentu output yang dihasilkan.

Dalam sistem semacam ini, konten yang muncul bukanlah hasil langsung dari permintaan pengguna, melainkan dari prompt yang telah ditulis ulang oleh model itu sendiri. Prompt versi baru tersebut kemudian diteruskan ke tahap generasi dan publikasi tanpa sepengetahuan pengguna. Kondisi ini mengesampingkan tanggung jawab karena pengguna tidak pernah melihat atau menyetujui bentuk akhir prompt yang sebenarnya menghasilkan konten. Meskipun intervensi tersebut berlangsung secara tersembunyi, perusahaan memegang kendali signifikan atas arah dan karakter output

Selain intervensi pragenerasi, banyak model juga menerapkan kontrol pascagenerasi dengan menggunakan sistem pengenalan gambar untuk mendeteksi konten ofensif atau ilegal sebelum ditampilkan atau dipublikasikan. Dalam praktiknya, Grok memilih untuk menandai gambar tertentu sebagai NSFW, sehingga pengguna harus mengkliknya secara aktif untuk melihat isi konten. Namun, penandaan ini sendiri merupakan pilihan kebijakan. Alat deteksi yang sama dapat digunakan untuk menyembunyikan konten sepenuhnya atau mencegahnya beredar di linimasa publik.

Keputusan untuk tetap mengizinkan konten terdeteksi sebagai berisiko agar dapat diakses publik mencerminkan pilihan manusia dalam mengatur distribusi materi yang diketahui bermasalah. Ketika sebuah sistem mampu mengenali potensi bahaya, tetapi secara sadar memilih hanya memberi label peringatan alih-alih memblokirnya, maka keputusan tersebut bersifat editorial. Dalam konteks ini, platform tidak lagi sekadar menjadi perantara, melainkan turut berperan sebagai pengembang sekaligus penerbit dari konten yang dihasilkannya sendiri.

3. Posisi Elon Musk dan tanggung jawab eksekutif dalam desain dan implementasi Grok

Dalam struktur kepemimpinan (board of director) xAI dan X, Elon Musk memegang peran sentral sebagai pendiri sekaligus CEO yang menentukan arah pengembangan dan integrasi produk. Grok tidak dikembangkan sebagai eksperimen terisolasi, melainkan sengaja ditempatkan dalam ekosistem media sosial dengan jangkauan publik yang sangat luas. Konsekuensinya, setiap keputusan teknis yang diambil memiliki dampak langsung di ruang publik. Dalam konteks ini, tanggung jawab eksekutif tidak dapat dipisahkan dari efek sistemik yang dihasilkan oleh teknologi tersebut.

Upaya untuk memindahkan seluruh tanggung jawab kepada pengguna mengabaikan realitas bahwa desain, batasan operasional, dan mekanisme distribusi konten ditentukan pada tingkat manajerial. Musk dan jajaran kepemimpinannya memiliki kewenangan penuh untuk menetapkan standar moderasi, memperketat pengendalian, atau bahkan menutup sama sekali kemungkinan jenis konten tertentu dihasilkan dan disebarkan. Ketika opsi-opsi tersebut tidak dipilih atau justru diarahkan untuk tetap membuka ruang bagi konten nonkonsensual, persoalan yang muncul tidak bisa dipandang sebagai kegagalan teknis semata. Ia merupakan buah refleksi dari keputusan kepemimpinan yang membawa konsekuensi etis sekaligus hukum.

4. Menilai kembali akuntabilitas dan kendali di era Generative AI

Kasus Grok menunjukkan betapa bermasalahnya narasi yang menggambarkan generative AI sebagai teknologi yang tak terkendali. Pandangan semacam ini kerap digunakan untuk menyamarkan peran manusia di balik sistem. Padahal, generative AI bukanlah entitas yang bergerak bebas di luar kendali. Ketidakpastian output yang dihasilkan lebih tepat dipahami sebagai konsekuensi dari keputusan tentang seberapa jauh kendali itu sengaja dilonggarkan.

Perlu diingat bahwa saat ini kita hidup dalam era generative AI yang penuh kesalahpahaman. Pemahaman publik sering kali jauh tertinggal dari realitas teknis atau tercampur dengan konsep AI lain yang beroperasi dalam kerangka berbeda. Penyederhanaan berlebihan terhadap arsitektur model justru berbahaya, terutama ketika hal itu menutupi tingkat keterlibatan manusia dalam membentuk perilaku sistem. Ketika kompleksitas ini direduksi menjadi sekadar “AI yang berulah sendiri,” tanggung jawab manusia secara sistematis tersingkir dari perbincangan.

Grok tidak lahir secara organik, melainkan dibentuk secara intensif oleh keputusan para perancang dan pengelolanya. Poin-poin seperti bagaimana model merespons perintah, batasan apa yang diberlakukan, hingga konten apa yang tetap diizinkan beredar merupakan keputusan secara sadar. Karena itu, Elon Musk beserta jajaran di xAI seyogyanya memikul tanggung jawab yang signifikan atas apa yang dihasilkan Grok dan apa yang dipublikasikan X sebagai respons atas permintaan pengguna. Ketika sistem dibiarkan untuk menghasilkan konten yang merendahkan dan menelanjangi perempuan tanpa persetujuan, tujuan sistem tersebut menjadi terlihat. Ia sebenarnya dapat menolak pelecehan, tetapi memilih untuk tidak melakukannya. Dalam kondisi seperti ini, akuntabilitas bukan hanya persoalan etika, melainkan keharusan mendesak yang tak boleh diabaikan.

![[QUIZ] Coba Tes Kepribadian Ini, Kamu Tim Android atau iPhone?](https://image.idntimes.com/post/20240415/kuis-tim-iphone-atau-tim-android-d76ab058e33f53a6ca1fe45da2088331.jpg)

![[QUIZ] Cara Kamu Mengatur Password Ungkap Tingkat Keamanan Dirimu](https://image.idntimes.com/post/20250218/pexels-padrinan-2882630-a5544ac6e438978a52774589906c8ddb-5bb289f7865ac0ea46acfb5a2af43b2c.jpg)