Meta Rilis Llama 4, Model AI dengan Jendela Konteks Super Panjang

- Meta merilis Llama 4 dalam tiga varian: Scout, Maverick, dan Behemoth

- Llama 4 memiliki kemampuan memproses konteks super panjang hingga 10 juta token

- Kemampuan multimodal Llama 4 memungkinkannya memahami teks, gambar, dan video secara bersamaan

Tiada hari tanpa inovasi baru di dunia kecerdasan buatan (AI). Meta baru saja mengumumkan peluncuran rangkaian model AI terbarunya yang bernama Llama 4. Peluncuran ini hadir dalam tiga varian utama, yakni Scout, Maverick, dan Behemoth. Model-model terbaru ini diklaim memiliki kemampuan memproses konteks super panjang dan fitur multimodal yang canggih.

Llama 4 ini hadir di tengah persaingan sengit di industri AI. Dilansir dari TechCrunch, kesuksesan DeepSeek, yang mampu menyaingi model Llama sebelumnya telah memecut Meta untuk bergegas mengembangkan model terbarunya. Mari kita telusuri lebih dalam mengenai Llama 4 dalam artikel berikut!

1. Tiga varian Llama 4 dengan berbagai keunggulan

Meta merilis Llama 4 dalam tiga varian yang masing-masing memiliki keunggulan tersendiri. Llama 4 Scout menjadi model terkecil namun memiliki kemampuan luar biasa. Model ini hadir dengan 17 miliar parameter aktif yang didukung 16 expert, serta total 109 miliar parameter. Keunggulan utama Scout terletak pada jendela konteks super panjangnya yang mencapai 10 juta token, setara dengan sekitar 15 ribu halaman teks.

Llama 4 Maverick dirancang sebagai model yang seimbang untuk berbagai kebutuhan umum. Model ini memiliki 17 miliar parameter aktif dengan 128 expert, serta total 400 miliar parameter. Maverick menawarkan keseimbangan antara performa tinggi dan efisiensi komputasi. Jendela konteks Maverick mencapai 1 juta token, setara dengan sekitar 1.500 halaman teks.

Sementara itu, Llama 4 Behemoth menjadi model terbesar yang masih dalam tahap pengembangan. Mengutip blog Meta, model ini hadir dengan spesifikasi monster 288 miliar parameter aktif, 16 expert, dan hampir 2 triliun total parameter. Behemoth diposisikan sebagai model guru yang digunakan untuk mentransfer pengetahuan ke model yang lebih kecil seperti Scout dan Maverick.

Ketiga model ini sudah mendukung kemampuan multimodal, mampu memproses input berupa teks, gambar, dan video. Namun saat ini, hanya Scout dan Maverick yang tersedia untuk diunduh, sementara Behemoth masih dalam tahap pengembangan. Meta mengklaim Behemoth mampu mengungguli GPT-4.5, Claude 3.7 Sonnet, dan Gemini 2.0 Pro dalam beberapa benchmark STEM.

2. Teknologi canggih di balik Llama 4

Llama 4 menggunakan arsitektur Mixture of Experts (MoE) yang menjadi kunci efisiensinya. Berbeda dengan model AI biasa yang mengaktifkan seluruh parameter untuk setiap token, MoE hanya mengaktifkan sebagian parameter sesuai kebutuhan. Pendekatan ini membuat pemrosesan data lebih efisien dan hemat daya.

Kemampuan multimodal Llama 4 memungkinkannya memahami teks, gambar, dan video secara bersamaan. Model ini dilatih dengan dataset beragam yang mencakup lebih dari 30 triliun token, dua kali lipat data pelatihan Llama 3. Hal ini membuat Llama 4 lebih cerdas dalam memahami berbagai jenis konten.

Meta juga mengembangkan teknik pelatihan baru yang membuat model dapat beradaptasi lebih baik. Teknik ini memungkinkan penyesuaian parameter penting antar model berbagai ukuran. Hasilnya, Meta bisa bereksperimen pada model kecil dan menerapkan temuan pada model besar dengan lebih efisien.

3. Performa Llama 4 dibandingkan model AI lainnya

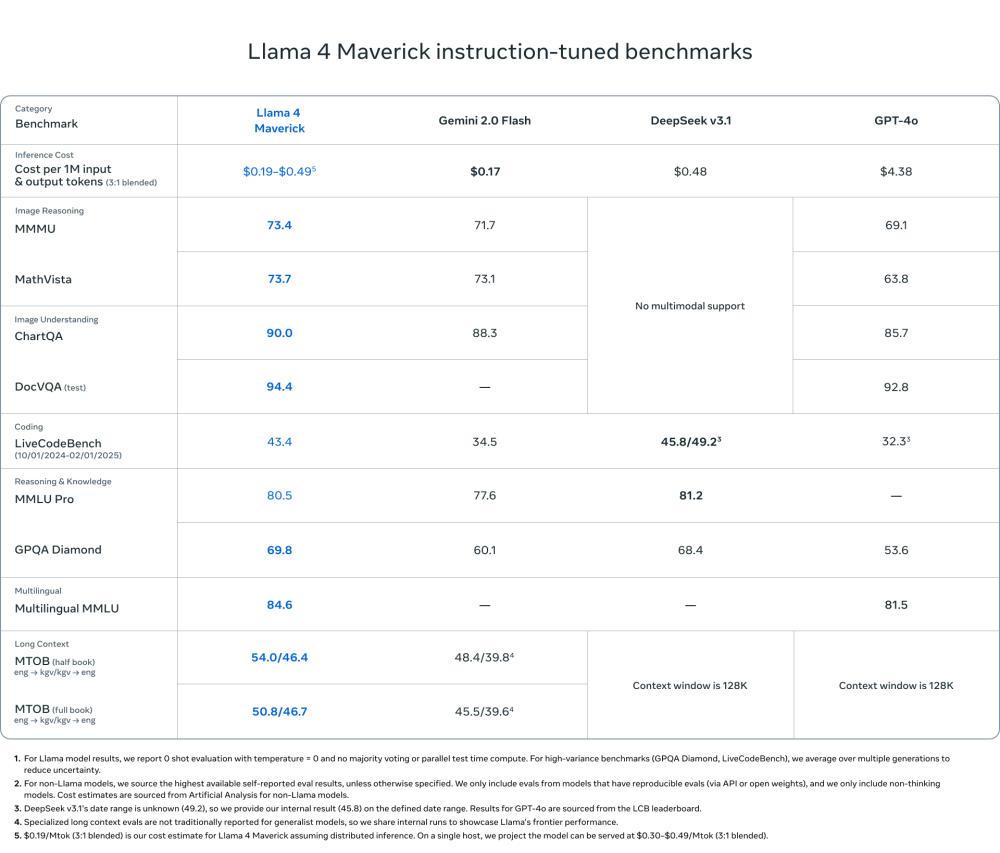

Llama 4 Maverick menunjukkan performa sangat baik dalam berbagai tolok ukur dibandingkan model kompetitor. Dalam pemahaman gambar, Maverick meraih skor 90,0 pada ChartQA, melampaui Gemini 2.0 Flash (88,3) dan GPT-4o (85,7). Pada DocVQA, Maverick mencapai skor 94,4, unggul dari GPT-4o yang hanya meraih 92,8. Kemampuan ini menjadikan Maverick pilihan tepat untuk tugas-tugas yang melibatkan analisis dokumen visual.

Dalam coding, Maverick menorehkan skor 43,4 pada LiveCodeBench, jauh di atas GPT-4o (32,3) dan Gemini Flash (34,5). Model ini bahkan hampir menyamai DeepSeek v3.1 yang mencapai 45,8 meski DeepSeek memiliki parameter aktif lebih banyak. Pada pengujian penalaran dan pengetahuan, Maverick meraih 80,5 pada MMLU Pro dan 69,8 pada GPQA Diamond. Angka ini mengungguli Gemini Flash yang masing-masing hanya mencapai 77,6 dan 60,1.

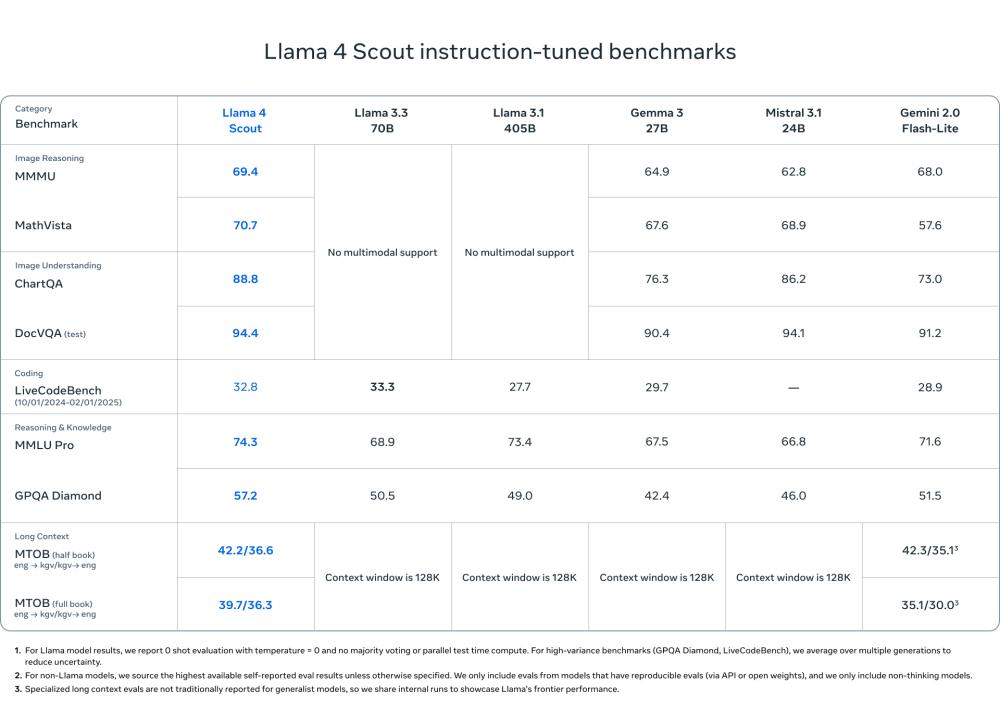

Scout juga tidak kalah mengesankan dengan kemampuan yang seimbang untuk ukurannya. Dalam pemahaman gambar, Scout mencapai 88,8 pada ChartQA dan 94,4 pada DocVQA, mengalahkan Gemini 2.0 Flash-Lite (73,0 dan 91,2) dan Gemma 3. Pada tolok ukur penalaran gambar seperti MMMU dan MathVista, Scout meraih skor 69,4 dan 70,7, unggul dari Gemma 3 (64,9 dan 67,6), Mistral 3.1 (62,8 dan 68,9), dan Gemini Flash-Lite (68,0 dan 57,6).

Llama 4 Behemoth, meski masih dalam pengembangan, menunjukkan potensi menarik pada tolok ukur STEM. Model ini meraih skor 95,0 pada MATH-500, lebih tinggi dari Gemini 2.0 Pro (91,8) dan jauh melampaui Claude Sonnet 3.7 (82,2). Pada GPQA Diamond, Behemoth mencapai 73,7, mengungguli Sonnet 3.7 (68,0), Gemini 2.0 Pro (64,7), dan GPT-4.5 (71,4).

Meta juga menyoroti perbaikan Llama 4 terkait bias politik. Model ini diklaim lebih netral dalam merespons topik politik dan sosial yang kontroversial. Llama 4 hanya menolak sekitar 2 persen pertanyaan tentang topik politik dan sosial yang diperdebatkan, turun dari 7 persen pada Llama 3.3. Meta menyebutkan bahwa Llama 4 secara dramatis lebih seimbang dalam merespons pertanyaan yang bervariasi.

4. Ketersediaan dan cara mengakses Llama 4

Saat ini, Llama 4 Scout dan Maverick telah tersedia untuk diunduh melalui situs resmi Llama dan platform Hugging Face. Model-model ini dirilis sebagai open source, namun dengan batasan penting. Perusahaan yang memiliki lebih dari 700 juta pengguna aktif bulanan harus meminta lisensi khusus dari Meta.

Selain mengunduh model, pengguna juga dapat mengakses Llama 4 melalui Meta AI yang terintegrasi di berbagai platform. Meta telah memperbarui Meta AI di WhatsApp, Messenger, dan Instagram Direct untuk menggunakan Llama 4 di 40 negara. Namun, fitur multimodal saat ini masih terbatas pada bahasa Inggris di Amerika Serikat.

Melansir DataCamp, pengguna dapat menjalankan Llama 4 Maverick pada komputer dengan Nvidia H100 DGX atau dengan sistem terdistribusi untuk efisiensi maksimal. Sementara itu, Scout bahkan lebih efisien karena dapat berjalan pada satu GPU H100. Ini membuatnya ideal untuk developer individu atau perusahaan dengan sumber daya komputasi terbatas.

Dari sisi efisiensi biaya, Llama 4 tampak cukup bersaing. Melansir VentureBeat, biaya pemrosesan untuk Llama 4 Maverick diperkirakan berkisar antara 0,19 hingga 0,49 dolar AS (sekitar Rp3.200 hingga Rp8.200) per 1 juta token. Estimasi ini menggunakan asumsi campuran 3:1 token input dan output. Angka ini jauh lebih murah dibandingkan GPT-4o yang diperkirakan sekitar 4,38 dolar AS (sekitar Rp74 ribu) per juta token.

Rilisnya Llama 4 menjadi kabari baik bagi ekosistem AI open source. Peningkatan kemampuan konteks panjang, multimodal, dan efisiensi komputasi yang ditawarkan menjadi angin segar bagi industri AI. Apakah kamu tertarik mencoba Llama 4 untuk kebutuhanmu?